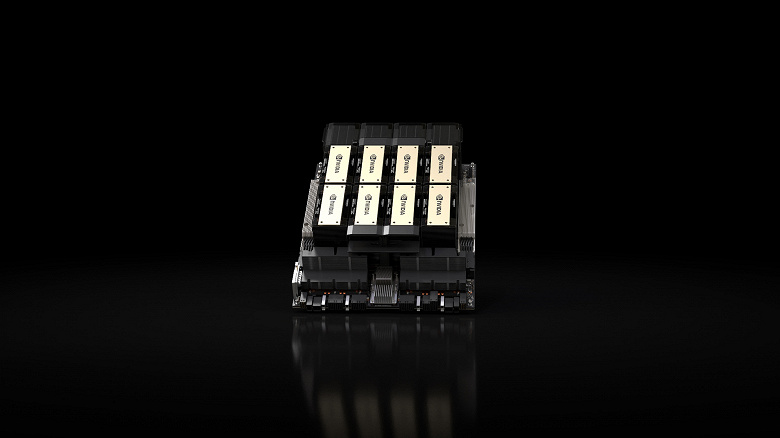

Ускоритель Nvidia H100, который является самым желанным продуктом для компаний, занимающихся современными генеративными моделями ИИ, теперь не самый производительный в мире. Сегодня Nvidia представила модель H200.

Правда, технически это не какая-то совсем уж новая модель. Более того, судя по всему, во многом это полная копия H100. Сама Nvidia не указывает характеристики GPU, но указывает ровно ту же производительность в TFLOPS, а это значит, что GPU остался тем же: с 16 896 ядрами CUDA.

Отличие же новой версии заключается в подсистеме памяти. Это первый ускоритель с памятью HBM3e, и использование такой памяти обеспечивает существенный прирост пропускной способности, что крайне важно в задачах ИИ.

Если точнее, H200 оснащается 141 ГБ памяти с пропускной способностью 4,8 ТБ/с против 80 ГБ и 3,35 ТБ/с у H100. Может показаться, что это не особо важно, и в ряде задач так и будет, но сама Nvidia демонстрирует примеры, когда H200 опережает H100 на величину вплоть до 90%, то есть почти двукратно! И это при том же GPU и основных характеристиках.

Поставки нового решения стартуют только во втором квартале 2024 года. Это притом, что в следующем году ожидается ускоритель B100 совершенно нового поколения.

H200 будет доступен в серверных платах Nvidia HGX H200 с четырех- и восьмипроцессорными конфигурациями. Он также доступен в составе суперчипа Nvidia GH200 Grace Hopper с HBM3e, анонсированного в августе.