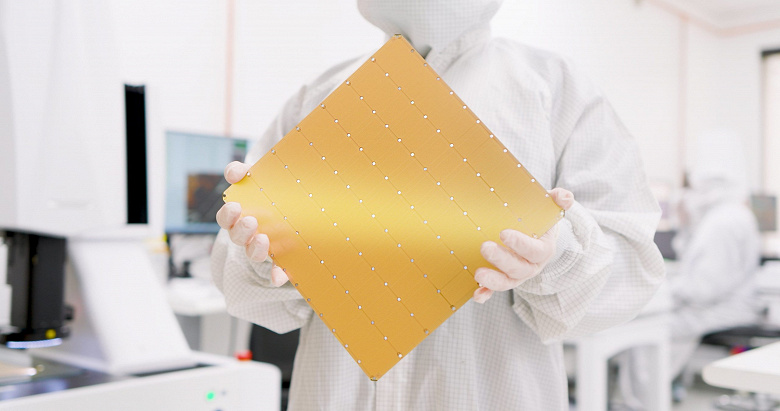

Исполинские микросхемы Cerebras WSE-3 размером с iPad способны запускать самую быструю на сегодня нейросеть на скорости на порядок выше, чем лучшие облачные серверы на основе GPU.

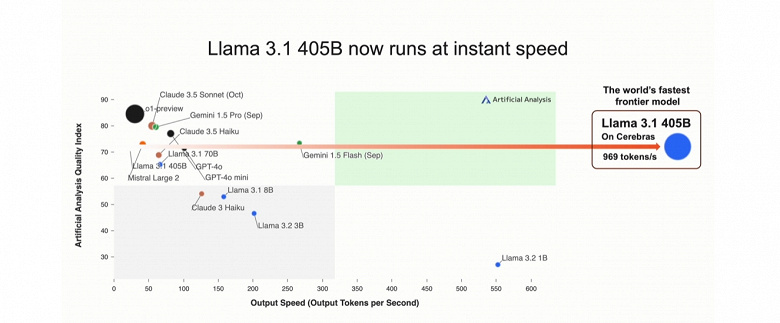

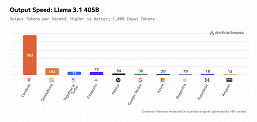

Как рассказала компания Cerebras, она запустила клиентскую рабочую нагрузку на новой модели Llama 3.1 405B со скоростью 969 токенов/с, и это новый рекорд для модели Frontier.

Llama 3.1 405B на Cerebras — самая быстрая модель Frontier в мире — в 12 раз быстрее, чем GPT-4o, и в 18 раз быстрее, чем Claude 3.5 Sonnet.

Модель была запущена на облачном сервисе Cerebras Inference, который использует те самые гигантские микросхемы WSE-3. Cerebras всегда заявляла, что её сервис Inference является самым быстрым в генерации токенов больших языковых моделей.

Когда он был впервые запущен в августе, было заявлено, что Cerebras Inference примерно в 20 раз быстрее, чем графические процессоры Nvidia, работающие через облачных провайдеров, таких как Amazon Web Services, если оценивать на моделях Llama 3.1 8B и Llama 3.1 70B. Теперь же мы имеем результат на гигантской модели Llama 3.1 405B с 405 млрд параметров.

Чтобы проиллюстрировать, насколько это быстро, Cerebras поручила своему сервису создать шахматную программу на языке Python. Cerebras Inference справился примерно за 3 секунды, а Fireworks — самый быстрый облачный сервис ИИ, оснащенный графическими процессорами — за 20 секунд.

Также компания похвасталась, что всего лишь одна микросхема WSE-2 превзошла суперкомпьютер Frontier в 768 раз в моделировании молекулярной динамики. А Frontier с 2021 года был самым быстрым суперкомпьютером в мире, и лишь сейчас его сместил El Capitan.

Напомним, Cerebras WSE-3 содержит 4 трлн транзисторов, 900 000 ядер и 44 ГБ памяти с пропускной способностью 21 ПБ/с.