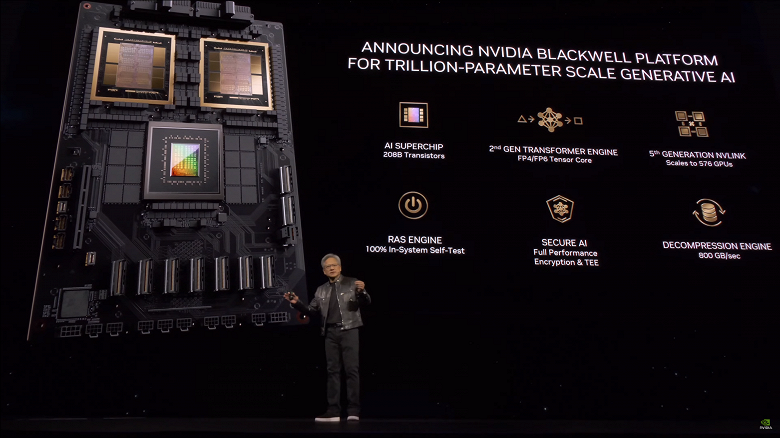

Компания Nvidia вчера представила гигантский GPU Blackwell и решения на его основе. Пока есть не все данные, хотя сегодня часть пробелов мы заполнили. Теперь же пришёл черёд поговорить о прямом применении новых ускорителей — обучении ИИ.

Несмотря на то что новый GPU производится по техпроцессу 4 нм, пусть и улучшенному, Nvidia говорит о гигантском приросте энергоэффективности. К примеру, на фоне H100 новое решение якобы снижает стоимость обучения ИИ и энергопотребление до 25 раз.

Но есть и более наглядный пример. По словам Nvidia, для обучения модели с 1,8 трлн параметров требуется 8000 графических процессоров Hopper и 15 МВт мощности либо же всего 2000 графических процессоров Blackwell и 4 МВт. В тесте LLM GPT-3 со 175 млрд параметров GB200 в семь раз опережает H100.

Для объединения нескольких графических процессоров в единую систему Nvidia разработала новый коммутатор NVLink. И по транзисторному бюджету он даст фору почти любому GPU на рынке: чип состоит из 50 млрд транзисторов.

Как и ранее, Nvidia представила и полностью готовую систему. Называется она GB200 NVL72 и содержит 36 ускорителей GB200 Grace Blackwell Superchip, то есть 72 новых GPU. Система имеет жидкостную СО и предлагает производительность обучения ИИ в 720 PFLOPS или 1,4 ExaFLOPS для вывода. Ещё один интересный факт о GB200 NVL72: внутри каждой системы проложено более 3 км кабелей. Nvidia говорит, что одна такая система может запускать модель ИИ с 27 трлн параметров.

Для самых крупных клиентов у Nvidia есть DGX Superpod — он объединяет восемь GB200 NVL72, обеспечивая 11,5 ExaFLOPS вычислений в режиме FP4.