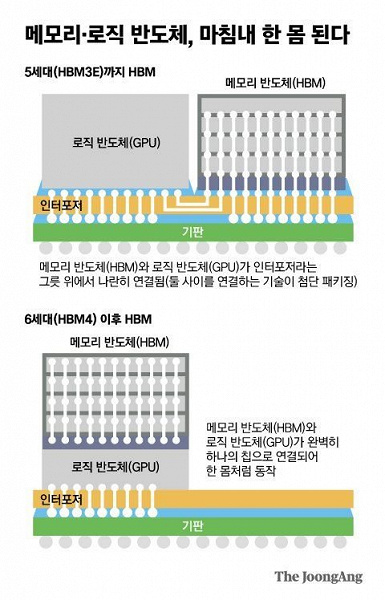

Память HBM4 появится на рынке лишь через несколько лет, но уже сейчас стало известно, что её появление может быть сопряжено с небольшой революцией в области полупроводникового производства. Как сообщается, компания Hynix работает с Nvidia и другими производителями над технологией, которая позволит разместить микросхемы памяти HBM4 непосредственно на вычислительном кристалле.

Сейчас память HBM размещают на одной подложке с CPU или GPU, но рядом. Размещение памяти на CPU/GPU не только изменит способ обычного соединения логических устройств и устройств памяти, но и изменит способ их изготовления.

Фактически это примерно то же самое, что и 3D V-Cache у AMD, только с иным типом памяти. Сейчас SK Hynix уже начала набор специалистов по разработке логических полупроводников, таких как центральные и графические процессоры и обсуждает свой метод проектирования интеграции HBM4 с несколькими компаниями, не имеющими собственных производственных мощностей, включая Nvidia.

Вероятно, Hynix и Nvidia изначально совместно разработают какой-то конкретный GPU, а затем компания TSMC произведёт этот чип и сразу же разместит поверх память HBM4. Учитывая тип памяти, речь явно о специализированных ускорителях для ИИ или ЦОД.

Hynix взялась за эту идею не просто так. Дело в том, что память HBM4 будет использовать 2048-битный интерфейс для подключения к хост-процессорам, поэтому последние будут чрезвычайно сложными и дорогими. Прямая связь памяти и CPU/GPU попросту выйдет дешевле.

Впрочем, пока рано делать какие-то итоги, так как на пути такой реализации есть весьма банальная проблема — нагрев. Потребление ускорителя Nvidia H100 очень велико, а через несколько лет такие решения могут потреблять намного больше. Память также потребляет немало, и когда всё это размещается рядом друг с другом, то проблем с охлаждением нет. А когда создаётся «бутерброд», нагрев значительно усиливается при меньшей площади итогового кристалла. Возможно, ускорители Nvidia через несколько лет будут изначально рассчитаны исключительно на жидкостное охлаждение.